一个基于VITS的简单易用的语音转换(变声器)框架,算法相关经验和成果是b站花儿不哭和Rcell经过半年时间做了上百组实验得出的当前的最优解

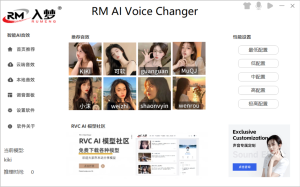

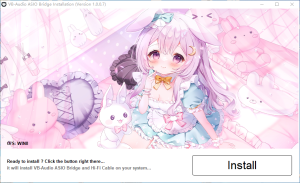

安装包为博主入梦自己集成,免费使用,包括多款训练好的音源文件和集成入梦虚拟声卡

Github

RVCAI变声器最新版本

夸克网盘

123云盘

百度网盘

UC网盘

迅雷网盘

谷歌网盘

![图片[1]-RVC AI变声器0604版本 入梦ai变声器入梦整合包 (PC)-](https://kbiao.net/wp-content/uploads/2024/08/aipc.png)

配置要求如下:

- 操作系统:需要Windows 10或Windows 11系统,对于老显卡驱动需要更新到最新版本。

- 显卡:要求显卡至少为NVIDIA GeForce GTX 1060或以上。

- CPU:需要四核心以上的处理器,如果CPU性能较差,可能会导致声音卡顿和延迟高。

- 麦克风:建议使用高质量的麦克风,声卡麦克风效果最佳。不建议使用手机耳机和笔记本自带的麦克风,因为效果较差。

相比于传统变声器的优点和缺点:

优点:

- AI变声不需要依赖个人声线,只需要清晰的语音即可,而传统变声器只能根据个人声线进行变化。

- 可以训练模型,加载各种声线,实现语气和声线的多样化。

缺点:

- 延迟较高,通常在1-5秒以上,而传统变声器可以实现最低无延迟。

- 咬字可能不清晰,气息奇怪,感情波动可能导致失真。

- 对配置要求较高,需要CPU和GPU的双重占用,配置较低的设备可能无法使用。虽然支持NVIDIA和AMD显卡,但NVIDIA显卡效果更好。

- 兼容性较差,AI变声目前还不成熟,存在闪退和稳定性问题。

博主观点:

- 建议使用独立声卡或高质量麦克风,以减少噪音对AI变声效果的影响。

- 对于CPU和GPU资源的压力较大,建议有独立显卡的用户使用。

- 如果使用MME协议输出,延迟在2秒到6秒之间,如果麦克风音质太低,设置低延迟声音会卡顿。

- 说话时不能大喊大叫,必须平稳说话,否则声音会变成气音。

- 打游戏时由于延迟较高,不适合实时通话,但发短语音消息效果很好。

简介:

使用top1检索替换输入源特征为训练集特征来杜绝音色泄漏。即便在相对较差的显卡上也能快速训练。使用少量数据进行训练也能得到较好结果(推荐至少收集10分钟低底噪语音数据)。可以通过模型融合来改变音色(借助ckpt处理选项卡中的ckpt-merge)。界面简单易用,可调用UVR5模型来快速分离人声和伴奏。

常见问题解答:

- ffmpeg error/utf8 error:大概率是音频路径问题,特别是路径中包含空格、()等特殊符号或中文路径时。

- 一键训练结束没有索引:可能是因为训练集太大卡住了添加索引的步骤,已通过批处理add索引解决内存需求过大的问题。

- 训练结束推理没看到训练集的音色:刷新音色后再查看,如果还没有报错,可以查看控制台和webui的截图,logs/实验名下的log。

- 如何分享模型:分享的是weights文件夹下大小为60+MB的pth文件,而不是logs文件夹下的几百MB的pth文件。

- Connection Error:可能是关闭了控制台(黑色窗口)。

- WebUI弹出Expecting value: line 1 column 1 (char 0):请关闭系统局域网代理/全局代理。

- 不用WebUI如何通过命令训练推理:可以先跑通WebUI,消息窗内会显示数据集处理和训练用命令行。

如何更新Windows 10或Windows 11系统上的老显卡驱动到最新版本?

更新Windows 10或Windows 11系统上的老显卡驱动到最新版本,可以参考以下步骤:

- 通过Windows Update自动更新:

- 点击开始菜单,选择“设置”选项。

- 进入到页面找到Windows 设置(Win+i)窗口,点击“更新和安全”,然后点击Windows Update。

- 点击“检查更新”(Check for updates),等待系统自动搜索并下载最新的驱动程序。

- 手动更新显卡驱动:

- 右键点击计算机,选择“管理”。

- 在“设备管理器”中找到“显示适配器”,双击打开。

- 右键点击你的显卡,选择“更新驱动程序软件”。

- 在弹出的窗口中,选择“浏览我的计算机以查找驱动程序软件”,然后选择自动搜索更新的驱动程序软件。

- 使用显卡制造商的驱动程序更新工具:

- 对于NVIDIA显卡,可以安装GeForce Experience软件,打开后进入“驱动程序”页面,查看当前已安装的驱动程序版本和可升级的版本,然后按照提示进行升级。

- 对于Intel显卡,可以通过Intel Graphics Driver的控制面板进入官方驱动下载页面,下载并安装最新的驱动程序。

- 检查DirectX诊断工具:

- 按下Windows键+R键,输入“DxDiag”并单击“确认”。

- 在DirectX诊断工具中,选择“显示”选项卡,查看显卡的名称和制造商,以及驱动程序版本信息。如果版本过低,可以手动下载并安装更新的驱动程序。

NVIDIA GeForce GTX 1060显卡在AI变声软件中的性能表现如何,与AMD显卡相比有何差异?

NVIDIA GeForce GTX 1060显卡在AI变声软件中的性能表现良好,能够满足基本的AI音频处理需求。根据,在一篇论文中,所有实验都是在配备Intel i7-8750H CPU和Nvidia GeForce GTX 1060显卡的系统上进行的,这表明GTX 1060能够处理复杂的音频数据和生成音频对抗样本,尽管具体性能指标未提及。

与AMD显卡相比,虽然提到了AMD锐龙8040系列处理器搭配AMD RDNA 3和AMD XDNA架构,提供高达16TOPS的NPU算力和高达39TOPS的整体算力,但这些信息主要关注处理器而非显卡。然而,从中可以看出,当使用AMD显卡时,AI变声软件的GPU使用率显著提高,达到80%甚至满载,这可能意味着在某些情况下,AMD显卡在处理AI音频任务时可能提供更高的性能或更高效的资源利用。

在使用AI变声软件时,如何优化CPU和GPU的资源占用,以减少延迟和提高稳定性?

在使用AI变声软件时,优化CPU和GPU的资源占用以减少延迟和提高稳定性,可以从以下几个方面入手:

- 增加batch size:通过增加batch size,可以提高GPU的内存利用率,尽量用完内存,避免空闲内存被其他程序占用,从而提升整体效率。

- 移植到GPU:将计算任务从CPU移植到GPU上执行,可以显著提高计算效率。例如,在语音识别中,通过创建CUDA相关矩阵类并封装矩阵操作,可以在GPU上实现高效计算。

- 并行优化:将不同路语音绑定到不同的CUDA stream,提高并行处理效率。这有助于充分利用GPU的多核能力,减少等待时间。

- 数据传输优化:减少CPU与GPU间的数据传输次数,降低延迟。可以通过优化数据加载和处理流程来实现这一点。

- 微架构优化:优化矩阵乘法和矩阵向量乘法的效率,提升整体性能。这包括使用高度优化的内核和自定义内存分配策略,以减少CPU-GPU之间的同步次数。

- LSTM凑batch优化:将不同请求的语言混合成一个batch,以减少网络传输量。这种方法可以减少数据传输的开销,提高整体处理速度。

- 算法优化:在音频处理中,可以替换标准数学库函数为更高效的替代品,如使用fastexp、fastpow等,以减少CPU使用率。同时,调整块大小以平衡延迟和CPU成本。

- 节省CPU能耗:在实时运算的声音合成中,可以通过关闭不必要的滤波器、LFO等来节省CPU能耗。此外,立体声采样比单声道采样需要更多的CPU资源,因此应根据实际需求选择合适的采样模式。

AI变声软件中模型训练的最佳实践是什么,特别是如何处理少量数据以获得较好的结果?

在AI变声软件中,模型训练的最佳实践涉及多个方面,尤其是在处理少量数据以获得较好的结果时。以下是一些关键策略:

- 使用预训练模型进行微调:根据,预训练模型可以作为初始参考模型,利用其生成的伪标签引导微调模型的训练。这种方法通过引入参考损失函数,重新计算模型预测输出的均方误差(MSE),实现MSE正则化,从而平衡模型对初始参考模型输出的依赖和源数据学习性能的损失。当θ值为0.1时,语音合成效果最佳。

- 数据增强和合成:中提到,为了增强训练数据,使用了合成数据集生成额外的数据,包括双语交谈、远端或近端单语交谈、有无近端噪音等不同场景。这有助于模型在面对少量真实数据时,能够更好地泛化和适应不同的环境条件。

- 深度学习模型的应用:指出,在处理少量语音数据时,传统的语音识别模型可能无法达到预期的准确率。然而,使用深度学习模型,如Transformer,可以显著提高在少量语音数据上的表现,达到较高的准确率。

- 数据质量控制:中提到,为了提高语音识别(ASR)和文本转语音(TTS)模型的性能,进行了改进的数据对齐和最终的数据过滤过程。这包括使用高质量样本集来训练新的对齐模型,并移除字符错误率(CER)超过一定阈值的样本,以确保使用高质量录音。

- 模型优化和调整:中提到,使用LAMB优化器进行模型训练,并调整学习率、权重衰减和dropout因子等超参数。对于小模型和大模型变体,分别进行了不同步长和批次大小的训练。在模型训练的最后阶段,仅在AudioCaps数据集上进行微调,以适应高质量的音频描述。

如何解决AI变声软件中的常见问题,例如ffmpeg error/utf8 error和一键训练结束没有索引的问题?

解决AI变声软件中常见的ffmpeg error/utf8 error和一键训练结束没有索引的问题,可以参考以下方法:

- 解决ffmpeg error/utf8 error:

- 根据,当使用ffmpeg生成音频文件时,如果文件名中包含中文,可能会出现乱码问题。解决方法是将文件名转换为Unicode编码。这可以通过编程实现,确保文件名在处理前被正确编码。

- 提到,遇到“utf-8 codec can’t decode byte invalid start byte”错误时,重启解释器后再执行问题可能得到解决。这表明在处理ffmpeg相关脚本或程序时,确保环境和解释器配置正确,有时简单的重启可以解决问题。

- 解决一键训练结束没有索引的问题:

- 提供了关于如何使用ffmpeg设置音频片段持续时间的信息,但并未直接提及索引问题。然而,它提到了使用

chunk_start_index参数来控制输出文件的索引。这表明在使用ffmpeg进行音频处理时,可以通过调整参数来控制输出文件的结构,包括索引信息。 - 虽然没有直接提及索引问题,但提到了从下载到训练到推理的整个过程,包括一些bug的解决方式。这暗示在AI变声软件的训练过程中,可能需要检查和调整训练脚本或配置,以确保训练过程能够正确生成所需的索引信息。

- 提供了关于如何使用ffmpeg设置音频片段持续时间的信息,但并未直接提及索引问题。然而,它提到了使用

解决这些问题通常需要检查和调整软件的配置、编码方式以及脚本处理逻辑。

![表情[kelian]-](https://kbiao.net/wp-content/themes/%E5%AD%90%E6%AF%947.8/img/smilies/kelian.gif)

暂无评论内容